Miles de conversaciones privadas con ChatGPT aparecen indexadas en Google. Anthropic cambia radicalmente su política de privacidad. Septiembre 2025: el mes que está redefiniendo la confianza en la inteligencia artificial.

El Doble Golpe que Sacude el Mundo Empresarial

Esta semana hemos sido testigos de dos crisis simultáneas que están redefiniendo cómo las empresas deben pensar sobre la inteligencia artificial. No es solo un problema técnico: es una crisis existencial para cualquier organización que use IA en sus operaciones diarias.

FRENTE 1: El Escándalo ChatGPT – Miles de Conversaciones Expuestas

La magnitud es alarmante: En agosto de 2025, miles de conversaciones privadas de ChatGPT aparecieron públicamente indexadas en Google, Bing y otros buscadores. El culpable no fue un hackeo, sino una función descontinuada de OpenAI llamada «make chats discoverable» (hacer chats descubribles).

¿Cómo ocurrió exactamente?

Esta función, ahora eliminada, convertía conversaciones privadas en páginas web públicas que los motores de búsqueda podían indexar automáticamente. Lo que los usuarios creían completamente privado, se volvió públicamente accesible con una simple búsqueda.

Casos reales que exponen el riesgo:

- Usuarios compartiendo CVs completos con información personal sensible

- Conversaciones sobre salud mental donde personas buscan ayuda psicológica

- Consultas legales confidenciales tratando a ChatGPT como abogado

- Información empresarial sensible discutida sin conocer los riesgos

- Datos médicos personales de pacientes consultando síntomas

Estado actual: Aunque Google ha comenzado a limitar la visibilidad de estas conversaciones, muchas siguen disponibles en otros buscadores y el daño reputacional ya está hecho.

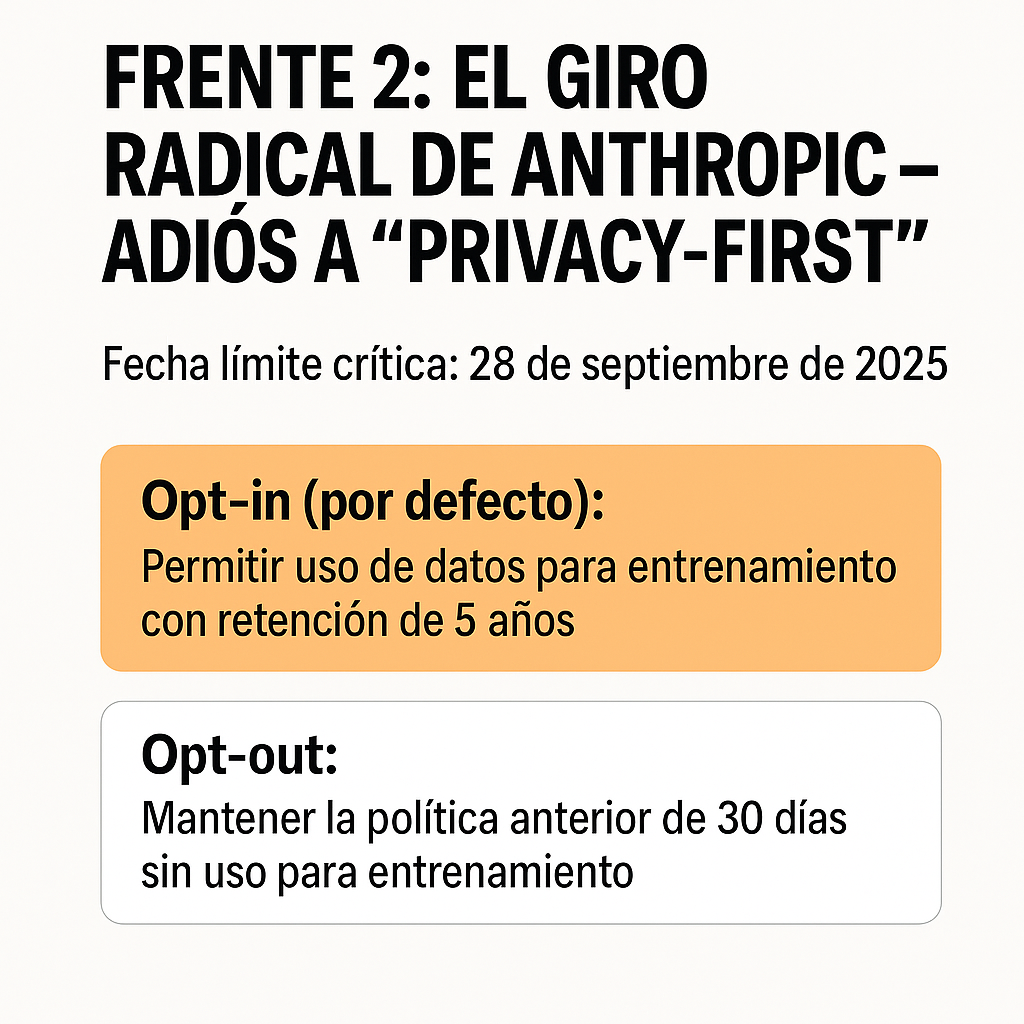

FRENTE 2: El Giro Radical de Anthropic – Adiós a «Privacy-First»

El cambio más impactante del año: Anthropic, que se posicionaba como la alternativa «privacy-first» a ChatGPT, acaba de invertir completamente su política de datos.

El cambio fundamental:

- Antes: Claude NO usaba datos de usuarios para entrenar modelos (retención de 30 días)

- Ahora: Por defecto, SÍ usará tus conversaciones para entrenamiento (retención hasta 5 años)

Fecha límite crítica: 28 de septiembre de 2025

Después de esta fecha, todos los usuarios consumer deben elegir activamente:

- Opt-in (por defecto): Permitir uso de datos para entrenamiento con retención de 5 años

- Opt-out: Mantener la política anterior de 30 días sin uso para entrenamiento

Nota importante: Este cambio NO afecta a Claude for Work, API empresarial, o planes Enterprise – solo usuarios individuales.

Las Implicaciones Empresariales Son Inmediatas

Riesgos Legales y de Compliance

- Violaciones de acuerdos de confidencialidad con clientes y socios

- Exposición de información privilegiada que puede resultar en demandas

- Incumplimiento de regulaciones como GDPR, HIPAA o normativas sectoriales

- Responsabilidad corporativa por filtración de datos de terceros

Impacto en la Reputación

- Pérdida de confianza de clientes e inversores

- Ventaja competitiva comprometida por estrategias expuestas

- Crisis de comunicación difícil de gestionar

- Daño a largo plazo en la percepción de marca

Costos Operacionales Inmediatos

- Auditorías de emergencia de todos los usos de IA

- Revisión legal de conversaciones potencialmente expuestas

- Implementación urgente de nuevas políticas de seguridad

- Formación de emergencia para todos los empleados

Guía de Acción Inmediata para Empresas

ACCIÓN URGENTE – Próximas 48 Horas

1. Auditoría de Emergencia

- ☐ Identificar quién en tu empresa usa ChatGPT y Claude

- ☐ Revisar si alguien ha usado la función «compartir» de ChatGPT

- ☐ Buscar en Google:

site:chat.openai.com "tu empresa"o términos relacionados - ☐ Documentar cualquier exposición encontrada

2. Configuración Inmediata de Claude

- ☐ Acceder a configuración de privacidad antes del 28 de septiembre

- ☐ Hacer opt-out del uso de datos para entrenamiento

- ☐ Verificar que la configuración se ha aplicado correctamente

- ☐ Comunicar el cambio a todos los usuarios corporativos

3. Política de Emergencia

- ☐ Prohibición temporal de compartir enlaces de ChatGPT

- ☐ Revisión obligatoria antes de usar IA con información sensible

- ☐ Canales seguros para discusiones confidenciales

ESTRATEGIA A MEDIO PLAZO – Próximas 2 Semanas

1. Política Corporativa de IA

NUNCA usar IA pública para:

- Información financiera confidencial

- Datos de clientes o pacientes

- Estrategias comerciales no públicas

- Información legal privilegiada

- Datos personales de empleados

- Información bajo acuerdos de confidencialidad2. Alternativas Seguras

- Claude for Work o ChatGPT Enterprise (políticas de privacidad diferentes)

- Soluciones on-premise para información crítica

- Compartimentación de información según nivel de sensibilidad

3. Formación y Concienciación

- Sesiones de emergencia sobre privacidad en IA

- Casos reales de lo que NO hacer

- Protocolos claros para diferentes tipos de información

El Panorama Actual: Más Allá de ChatGPT y Claude

Otros Casos Recientes

- Grok (X/Twitter): Más de 300,000 conversaciones privadas también aparecieron indexadas en Google

- Patrón común: Las funciones de «compartir» en plataformas de IA están creando exposiciones masivas

- Tendencia preocupante: Los usuarios tratan a la IA como terapeuta, abogado y confidente sin entender los riesgos

¿Por Qué Está Pasando Esto?

- Funciones mal diseñadas: Las opciones de «compartir» no eran verdaderamente privadas

- Falta de educación: Los usuarios no entienden las implicaciones de privacidad

- Presión competitiva: Las empresas de IA priorizan funcionalidades sobre privacidad

- Monetización de datos: El entrenamiento con datos de usuarios es valioso económicamente

El Futuro de la Privacidad en IA: Lo Que Viene

Tendencias Inevitables

- Más empresas seguirán el modelo de Anthropic: El entrenamiento con datos de usuarios será la norma

- Regulación más estricta: Europa ya está preparando normativas específicas para IA

- Segmentación del mercado: Versiones «enterprise» vs. «consumer» con políticas radicalmente diferentes

- Transparencia forzada: Las empresas deberán ser más claras sobre el uso de datos

Predicciones para 2026

- Auditorías obligatorias de uso de IA en sectores regulados

- Certificaciones de privacidad como requisito para contratos empresariales

- Seguros específicos para riesgos de IA y filtración de datos

- Nuevos roles: Chief AI Privacy Officer será común en grandes empresas

Cambios en el Comportamiento del Usuario

- Mayor conciencia sobre los riesgos de compartir información con IA

- Demanda creciente de soluciones de IA verdaderamente privadas

- Segmentación de uso: IA pública para tareas generales, soluciones privadas para información sensible

Lecciones Aprendidas y Recomendaciones Finales

Para Empresas

- Nunca asumas que «privado» significa realmente privado en plataformas de IA gratuitas

- Invierte en soluciones enterprise si manejas información sensible

- Forma a tu equipo sobre los riesgos reales de la IA

- Desarrolla políticas claras antes de que ocurra un incidente

Para Usuarios Individuales

- Trata toda conversación con IA como potencialmente pública

- Lee las políticas de privacidad y entiende los cambios

- Usa funciones de opt-out cuando estén disponibles

- Considera alternativas privadas para información sensible

Conclusión: El Momento de Actuar es AHORA

Esta no es una crisis futura: está ocurriendo en tiempo real. Los casos de ChatGPT y el cambio de Anthropic son solo la punta del iceberg de una transformación fundamental en cómo la industria de la IA maneja la privacidad.

Las empresas que actúen rápido tendrán ventaja competitiva y evitarán crisis de reputación. Las que ignoren estas señales de alarma pagarán el precio en forma de exposición de datos, problemas legales y pérdida de confianza.

La pregunta no es si tu empresa se verá afectada por estos cambios. La pregunta es: ¿estarás preparado cuando tu información confidencial aparezca en una búsqueda de Google?

El tiempo de actuar es ahora. El costo de no hacerlo puede ser irreversible.

Recursos y Enlaces de Referencia: